「Ultimate Vocal Remover GUI」 を用いて、曲から声のみを取り出したり、逆に声のみ消したりする方法を解説します。

UVRで音声分離を行うことで、誰でもRVC等を用いて、音声変換AIで歌ってみたを作成できるようになります。

また、楽曲から抽出した音声で学習もできますね。

1. UVRのインストール

動作要件など

- GPUを用いる場合、Nvidia RTX 1060 6GB が最小要件

- 少なくとも 8 GB の VRAM を搭載した Nvidia GPU が推奨

- AMD Radeon GPU は現時点ではサポートされていません

- 64ビットOSとのみ互換性

グラボを用いず変換することもできるので、とりあえず大抵のWindows 10以降のユーザーなら使えるハズです。

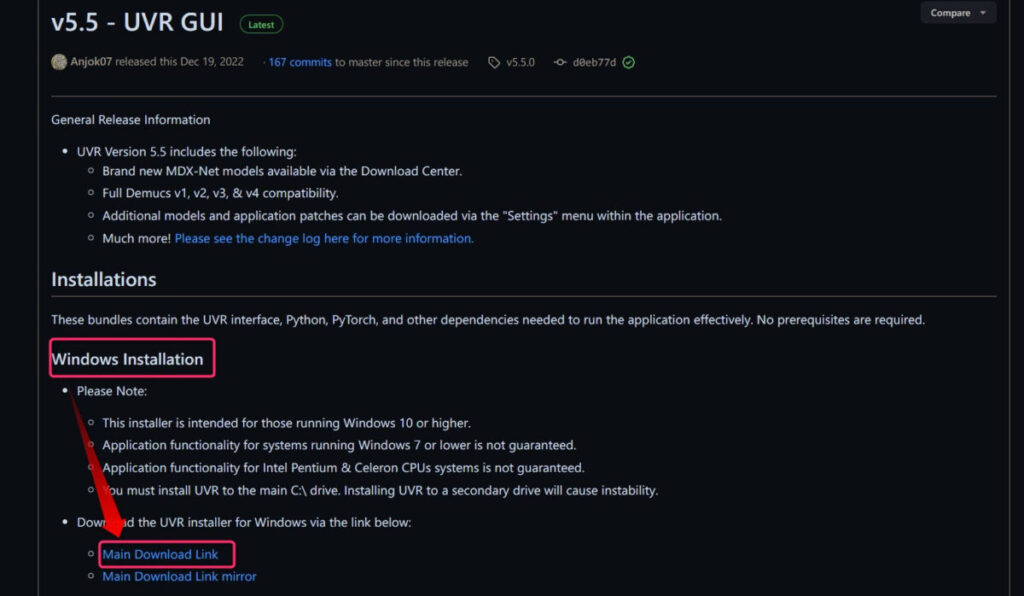

インストールを行う

まずは、Releaseページにアクセスし、Windows向けインストーラーをダウンロードします。

1GB以上あるので結構時間がかかります。

ダウンロードを終えたら、インストーラーを起動します。

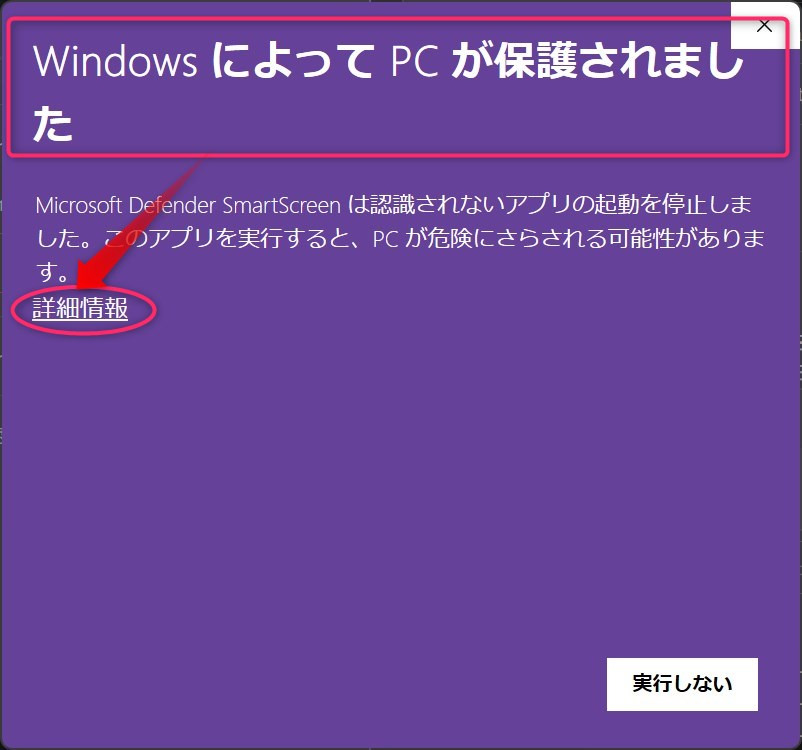

多分ダウンロード数が少ない実行ファイルを立ち上げる際におなじみの画面↓が現れるので、「詳細情報」をクリック。

そして「実行」を押せば完了!!

規約などに同意してインストールして下さい。

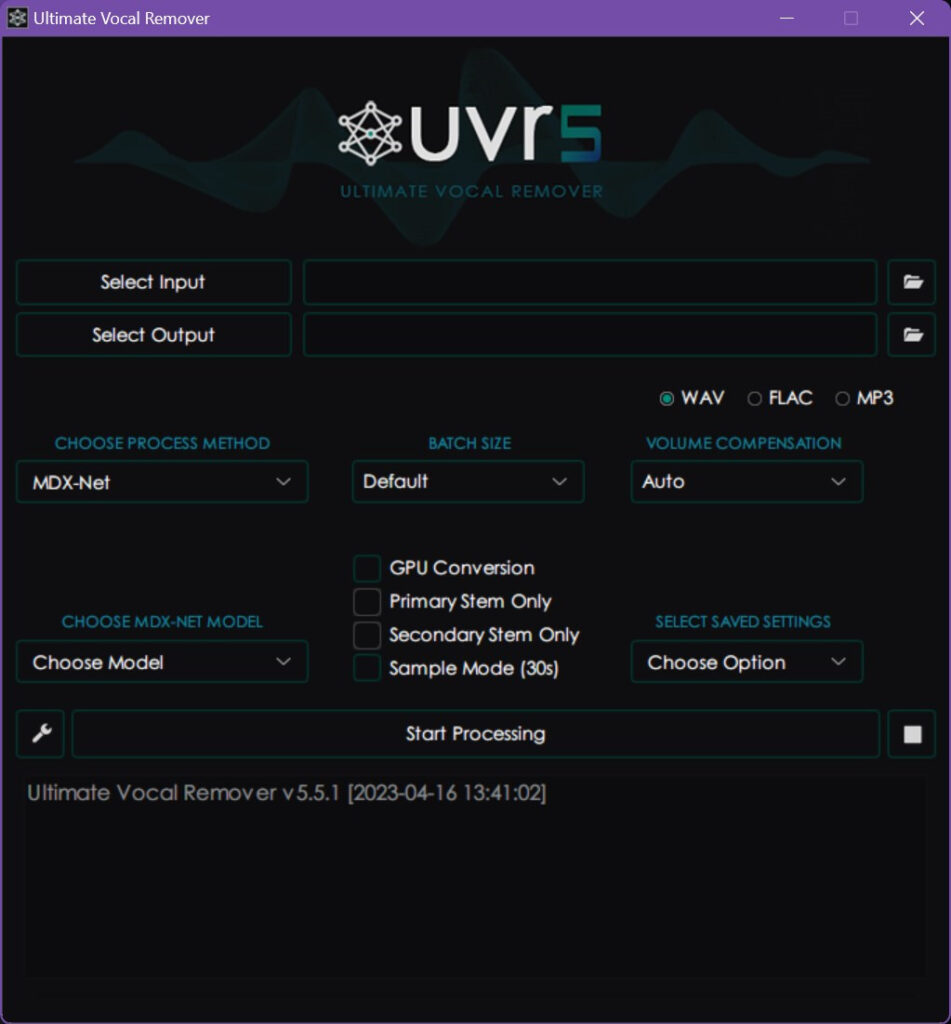

インストール成功後、起動するとこのようになります。

2.各種設定

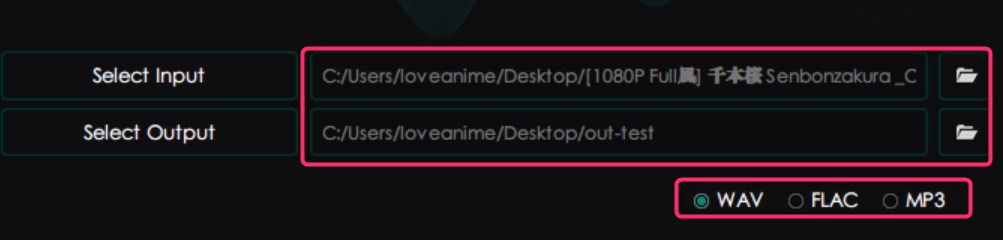

入出力設定

処理したい音声ファイルと、処理後の出力ファイルの保存場所をそれぞれ指定します。

そして出力音声フォーマットも指定します。

なお、wav形式以外のオーディオファイルの処理は別途 FFmpeg のインストールが必須です。

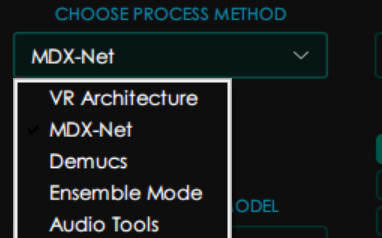

使用するプロセスメソッド選択

プロセスメソッドはそれぞれ特徴がありますが、楽曲からボーカル分離・抽出するならMDX-Netを使えば問題ないと思います。

なお、メソッドによっては設定項目が異なるため、以後の解説ではMDX-Net選択時の設定項目を取り扱います。

VR Architecture

- 「ハイエンド処理」を切り替える機能。

- 最新のVR Architectureのサポート

- Crop Size と Batch Size は、最新のアーキテクチャのみを使用するモデル専用です。

MDX-Net

- 「出力のノイズを除去」オプションを使用すると、よりきれいな結果が得られますが、処理時間は長くなります。このオプションは、ノイズ リダクションに取って代わりました。

- 「スペクトル反転」オプションは、スペクトル反転技術を使用して、よりクリーンなセカンダリ ステム結果を生成します。このオプションを使用すると、オーディオ エクスポート プロセスが遅くなる場合があります。

- セカンダリ ステムは、メイン ステムと同じ周波数カットオフになりました。

Demucs

- 6 ステム モデルを含む Demucs v4 モデルがサポートされるようになりました。

- ユーザーが「すべてのステム」を選択していない場合にのみ、選択したステムを混合物と反転させるのではなく、残りのステムを結合します。

- ユーザーが堅牢なボーカルまたはインストルメンタル モデルを通じて推論を実行し、生成されたインストゥルメンタル ミックスから残りのステムを分離できるようにする「前処理」モデル。このオプションは、他の Demucs で生成された非ボーカル ステムのボーカル ブリードを大幅に減らすことができます。

- 前処理モデルは、ボーカルと楽器を除くすべてのステムの Demucs 分離を対象としています。

Ensemble Mode

https://github.com/Anjok07/ultimatevocalremovergui

- アンサンブル モードが拡張され、次の機能が追加されました。

- 「平均化」は、最終結果を平均化する新しいアルゴリズムです。

- アンサンブルで無制限のモデル。

- さまざまなアンサンブルを保存する機能。

- すべての個々のステム タイプの出力をアンサンブルする機能。

- 独自のアンサンブル アルゴリズムを選択する機能。

- 一度に 4 つの Demucs ステムすべてをアンサンブルする機能。

Ensembleモードで複数モデルの結果を元にして飛躍的に高いボーカル除去効果を得るという方法もあります。

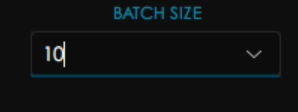

バッチサイズ選択

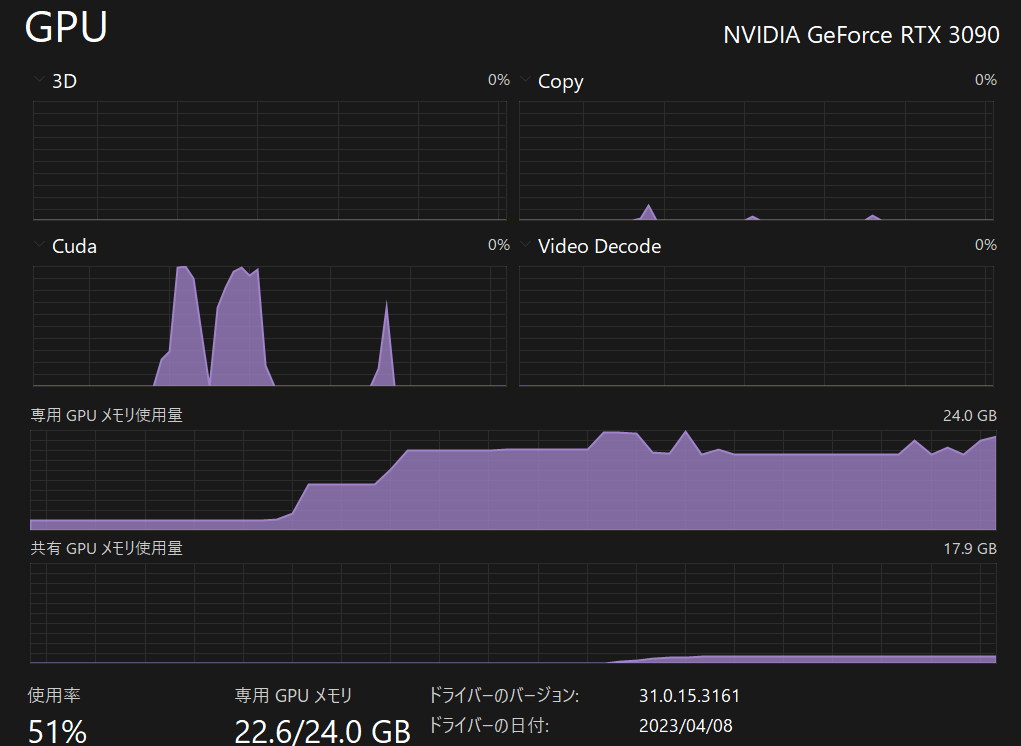

バッチサイズ10で消費VRAM23GB前後でした。

各自の環境に合わせて調整して下さい。

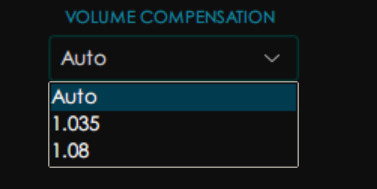

音量補正

ボリュームを大きめにもできるようですが、まあAutoでいいでしょう。

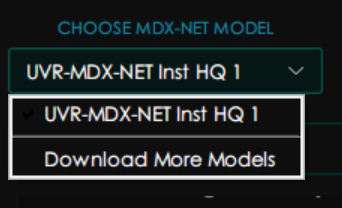

モデル選択

モデルをダウンロードしたり、選択したりできます。

デフォルトで最も精度が高い「UVR-MDX-NET Inst HQ 1」がダウンロードされているので、通常これを使用します。

ちなみに精度順に、UVR-MDX-NET Inst HQ 1, UVR-MDX-NET Main, UVR-MDX-NET 1 ,同2 ,同3のようです。

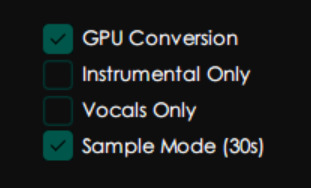

処理実行時の設定

- GPU Conversion:グラボを使用する

- lnstrumental OnIy:曲のみ(ボーカル除去、カラオケ音源化)

- Vocals Only:ボーカルのみ抽出(アカペラ化)

- Sample Mode(30s ):試しに冒頭30秒を処理

ボーカルの除去or抽出はここで指定します。

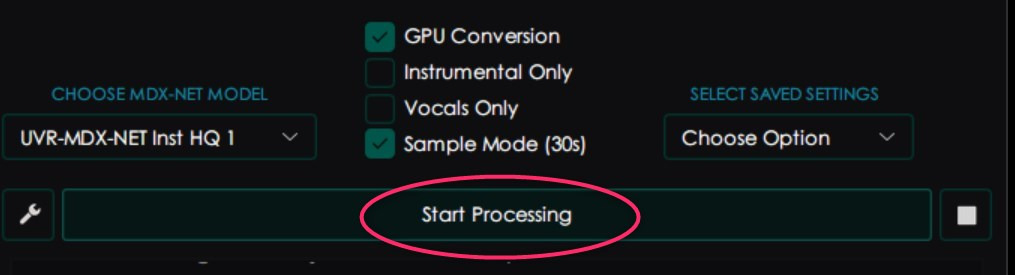

処理開始

Start Processingでスタートです。

3. 変換を実行!実力はいかに?!

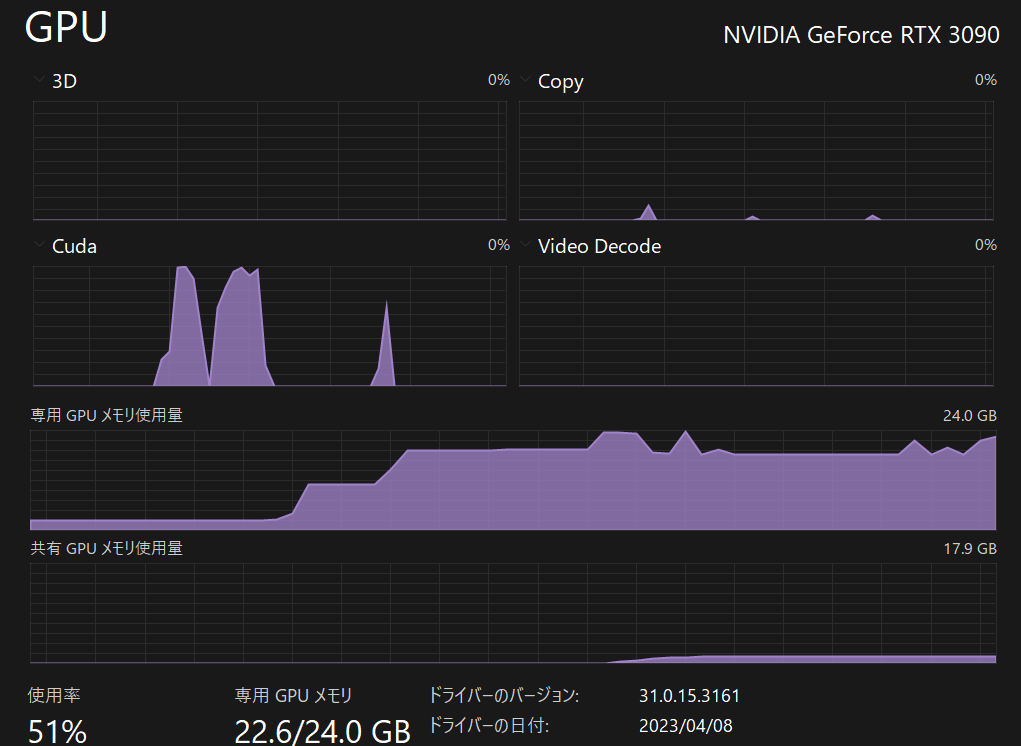

ハードウェア負荷

バッチサイズ10だとぎりぎり24GB内です。

4分30秒の楽曲に1分20秒程度かかりました。

実際に処理してみた

大抵の楽曲は欠片でもブログに置くとバチクソ面倒なことになるので、ここでは権利フリーと明記されたものを使用します。

フリーBGMusic氏の「Vocaloid ボカロ「ポップソング」ボカロ曲(著作権フリー)を作りました」を使用させていただきます。

ボーカルを抽出した場合:

※冒頭はイントロのため、20秒付近までボーカル無音区間です。

ボーカルを除去した場合:

すっごい高精度ですね!!

ここで抽出したボーカルをRVCなどで変換して好みの声にした後、ボーカルを除去した楽曲と結合すればあっという間に、好きな声で好きな歌を歌ってみたが作成できます。

逆に、好きな声を雑音なく抽出して学習に用いることもできますね。

まとめ 楽曲からボーカル分離or抽出できるUVR GUI

- UVR GUIのインストール

- 各種設定

- 入出力設定

- 使用するプロセスメソッド選択

- バッチサイズ選択

- 音量補正

- モデル選択

- 処理実行時の設定

- 処理開始!!

- RVCなどを使い、分離されたボーカルで色々する

UVRで楽曲からボーカルを分離・抽出できたら、音声AIのトレーニングもしたくなってきたという方はぜひこちらをご覧ください!!

似たものとして楽曲をドラムやボーカルなど種類ごとに分離する「Demucs」というAIもあります。

他にも色々と面白いAI関連の記事を書いています。合わせてご覧ください。

規制も倫理も無いFreedomGPTをグラボ不使用でWindowsにて動かす方法

画像生成AI「Stable Diffusion」を動かす方法

無料のCopilot「Amazon CodeWhisperer」を登録&VSCodeで使用する方法まとめ

実践的な使い方として、推しの子OP曲「アイドル」を物語シリーズのキャラ3人に歌ってもらいました。

(阿良々木月火,千石撫子,戦場ヶ原ひたぎ)

こちらで再生できます。